接到「女兒」的求救電話,竟不能相信自己的耳朵!今年年初,美國亞利桑那州的 Jennifer DeStefano 就遇到了「耳聽為虛」的騙局。據《紐約郵報》報導,這通來自「女兒」的電話,實則是一起利用 AI 聲音複製技術的勒索案。

那天下午,Jennifer DeStefano 收到了一個陌生電話號碼的來電。原本沒在意,但想起 15 歲的女兒正在外地滑雪,出於擔心就選擇了接聽。

誰料,聽到電話那頭傳來了女兒的哭喊聲:「媽媽!救我!」

緊接著,一位陌生男子開始發話:「你女兒在我這裡,如果打電話報警或通知任何人,就把你女兒帶到墨西哥去。」

恐慌之中, Jennifer DeStefano 還聽到電話那頭女兒的呼救,聲音非常真實。

男子還馬上談起了條件 —— 需要 100 萬美元的贖金才能放人。但得知無法支付那麼多贖金後,男子又改口稱:「拿 5 萬美元來換你的女兒。」

在頓感事情蹊蹺之後, Jennifer DeStefano 選擇了迅速聯絡丈夫,直到確認女兒正在安全地滑雪中,才倖免被騙。

事後回憶起通話細節時, Jennifer DeStefano 表示仍感到後怕,雖然如今明確這是電話詐騙,但想到「女兒的聲音」如此逼真,讓她細思極恐。

02.3秒即可生成,多起詐騙案發生經過多方證實,這是一起利用 AI 聲音生成技術進行的詐騙案。

針對這類基於 AI 的詐騙案,加州大學柏克萊分校電腦科學教授、柏克萊人工智慧實驗室成員 Hany Farid 對 AI 生成語音的原理,做出了詳細解釋。

AI 語音生成軟體,可以分析什麼讓人的聲音與眾不同(包括年齡、性別和口音),並搜尋龐大的聲音資料庫以找到相似的聲音,然後重新創造出相似整體效果的聲音。

它通常從 YouTube、Podcast、商業廣告、TikTok、Instagram 或 Facebook 等地方獲取音訊樣本。

此外,亞利桑那州立大學人工智慧專業電腦科學教授 Subbarao Kambhampati 還認為,AI 語音生成技術正在迅速改進:「以前,複製一個人的聲音需要從被被複製者身上獲取大量樣本。現在,只需三秒鐘就可以生成出一個接近你的聲音。」

該觀點也得到了 Hany Farid 的「證言」:「一個好的複製聲音可以用不到一分鐘的音訊生成,甚至幾秒鐘就足夠了。在 AI 軟體的幫助下,這類的語音複製服務只需每月 5 美元,任何人都可以使用。」

然而,由於目前這類技術幾乎沒有受到監督,類似的「詐騙案」也不勝列舉。

3 月,據《紐約郵報》報導,居住在匹茲堡的 Beth Royce 接到了「姐姐」的求救電話後,給綁匪寄了 1000 美元贖金。事後, Beth Royce 表示:「很難描述電話中‘姐姐’的聲音多麼真實。」

甚至,以往被認為安全的「聲紋」系統也存在明顯漏洞。

3 月,《衛報》澳洲版記者 Nick Evershed 表示,他使用人工智慧做出自己的聲音,進入了他的 Centrelink 自助服務帳戶。在《衛報》調查後發現,Centrelink 和澳洲稅務局(ATO)使用的聲紋安全系統其實是可以被欺騙的。

警方:小心陌生電話,社群媒體的個人資訊不公開!的確,在 ChatGPT、GPT-4 引領的浪潮之下, AI 提速科技變革帶來諸多便利,也難免讓眾人惶恐不安,例如:

Google DeepMind 基於深度學習的原始音訊生成模型 WaveNet,在語音合成的聲學模型建模中,可直接學習到採樣值序列的對應,能高度模仿人類聲音;

AI 語音演算法 MockingBird,號稱能5 秒內複製你的聲音並生成任意語音內容。

值得關注的是,當 AI 語音複製技術用於正當目的時,能幫助語音合成、語音翻譯、語音恢復等,但它用於非法目的時,將為偽造證據、欺詐勒索等行為提供可能。

知名安全機構 McAfee 對來自七個國家的 7054 人,針對 AI 詐騙進行了調查,結果顯示:近 1/4 的人遇到過某種形式的 AI 語音詐騙。

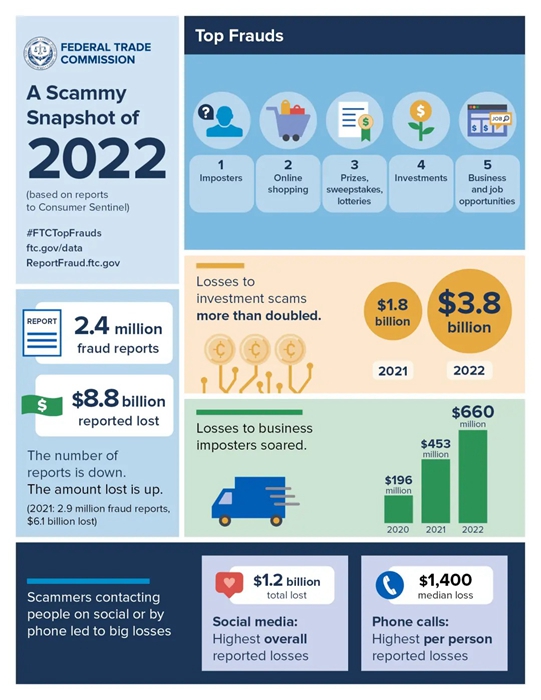

據聯邦貿易委員會最新發佈的資料顯示,在 2022 年因欺詐損失金額的案件中,「冒名頂替者詐騙」的數量排名第二,全年共損失了 26 億美元。此外,在 240 萬份欺詐報告中,最常見的是冒名頂替詐騙報告。

聯邦調查局專家表示,詐騙者經常在社群媒體上尋找目標。

為了避免成為此類騙局的受害者, FBI 鳳凰城辦公室的助理探員 Dan Mayo 敦促大家:社群平台的個人資料保持在私人模式,不要向公眾公開。

Dan Mayo 認為:「必須把那些東西鎖起來,一旦公開將會面臨被騙的風險,因為他們會尋找有關你的公開資訊,並隨之深入瞭解你。」

與此同時,對於那些不熟悉的區號的電話號碼、國際號碼,需要格外警覺。

目前,雖然尚不清楚有多少人接聽到通過 AI 語音複製進行假綁架的詐騙電話,但 Dan Mayo 表示這種情況「每天都在發生」。

加入T客邦Facebook粉絲團 固定链接 '「AI孫燕姿」同款技術被用來詐騙,母親險些被「AI女兒」聲音求助騙走100萬美元' 提交: June 26, 2023, 12:30am CST